[chapo]Pouvoir ressortir des informations pertinentes dans une masse toujours plus grande de données est devenu la priorité de beaucoup d’entreprises. De ce fait, de nombreuses solutions ont vu le jour pour entre autres extraire et transformer les données (outils d’ETL) ou visualiser les données (outils de Data Visualization). Mais le grand nombre d’outils utilisés dans le processus d’analyse de données depuis la collecte de celles-ci complique la tâche aux sociétés.[/chapo]

Heureusement, il existe maintenant des outils permettant de réaliser des analyses de bout en bout : des plateformes de Data Science. Ces outils comprennent comme fonctionnalités à la fois l’intégration, le nettoyage, l’exploration, l’analyse prédictive et la visualisation de données. Ils réunissent donc toutes les étapes de développement d’une analyse de données.

Ces plateformes possèdent de nombreux connecteurs pour ce qui est de l’intégration de données, dans le but de pouvoir se connecter au maximum de types de bases ou de fichiers de données. Pour pouvoir donner le plus de fonctionnalités possibles en termes d’analyse ou de visualisation, ces logiciels possèdent aussi des connecteurs à des solutions plus spécialisées dans ces domaines.

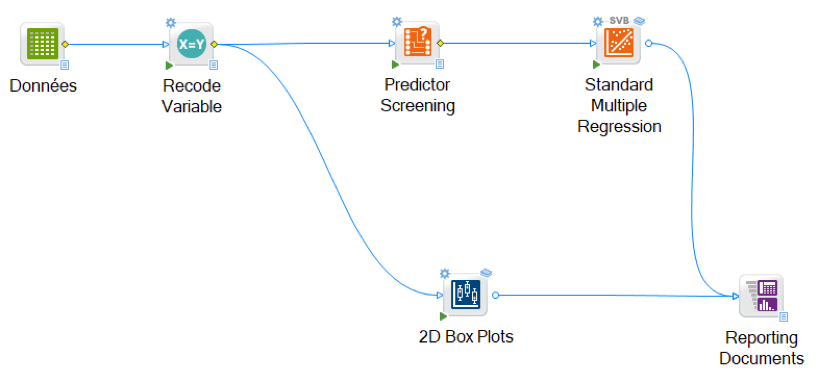

Un autre avantage de ces plateformes est la visualisation claire des étapes suivies lors des analyses de données via la création de workflows (flux de tâches), à la manière d’un outil d’ETL.

Selon l’étude du Gartner parue en février 2018 sur les plateformes de Data Science (voir ici), les leaders du domaine sont RapidMiner, KNIME, Alteryx, H2O.ai et SAS. Notons aussi la présence de deux challengers (selon les critères de l’étude), TIBCO et MathWorks. Dans cet article nous nous intéresserons plus particulièrement au cas de Statistica (TIBCO), une de ces plateformes de Data Science.

L’outil Statistica

L’analyse de données dans Statistica est composée de différents étapes de transformation de la donnée sous la forme de boîtes paramétrables et interconnectables (lorsque les étapes sont compatibles). L’utilisateur choisit les boîtes qu’il souhaite ajouter à son workflow, puis entre les paramètres adaptés à son analyse et à la boîte sélectionnée. Chaque boîte/étape dépend du résultat de la précédente (excepté la première qui dépend d’un fichier ou une base de données à entrer en paramètre).

Deux versions du logiciel sont disponibles :

• Statistica Desktop pour développer des workflows en local, cette version est utilisée surtout pour la fouille de données, qui ne nécessite pas des traitements trop importants,

• Statistica Server pour développer sur un serveur externe en collaboration, elle est préconisée pour déployer des algorithmes en production (notamment du Machine Learning) et permet de partager les workflows créés au sein de l’entreprise.

Les fonctionnalités utilisées en premier lors de la mise en place d’une analyse de donnés sont celles permettant l’intégration et la mise en forme des données. L’intégration se fait via des connecteurs donnant la possibilité de travailler sur des fichiers de données classiques de formats CSV, XML, TXT et bien d’autres, mais aussi sur des bases de données relationnelles et même sur HDFS (Hadoop Distributed File System).

En termes de mise en forme des données, on retrouve les mêmes capacités que pour les outils d’ETL (sur la partie Transform) : les filtres sur colonnes et lignes, les remplacements de valeurs manquantes, la sélection de variables, etc.

Le logiciel permet de réaliser de l’intégration de code Python et R pour créer des matrices de données, faire de la mise en forme et de la visualisation, ces langages étant ceux les plus couramment utilisés par les Data Scientist. On peut aussi connecter Statistica à des plateformes comme Azure ML, Algorithmia ou Apervita pour transférer des modèles d’analyse entre ces outils.

Quant à l’analyse statistique de données, la plateforme offre tout d’abord des statistiques exploratoires comme les tableaux de fréquences ou les matrices de corrélations. On retrouve ensuite un grand nombre d’analyses multivariées : analyse factorielle, analyse des fonctions discriminantes, régression linéaire et non linéaire, analyse des correspondances, analyse des séries chronologiques, arbres de classification, partitionnement de données…

Il est également possible de faire de la fouille de textes, comme par exemple de la racinisation de mots, des matrices de fréquences des mots ou de l’import de listes de « mots vides ».

Des analyses prédictives sont aussi disponibles : les réseaux de neurones, les SVM, le classifieur de Bayes naïf, la méthode des k plus proches voisins et les Forêts aléatoires entre autres. L’outil donne les erreurs de prédiction des algorithmes entraînés, et donne des moyens de comparer différents modèles de prédiction/classification, avec l’analyse de la courbe ROC par exemple en classification binaire.

Pour finir, ce logiciel est également capable de générer quelques visualisations de données (comme des histogrammes ou des boîtes à moustaches), et peut se connecter à des solutions spécialisées (comme Spotfire) si l’on a besoin de visualisations complexes.

Le point faible de l’outil est qu’il est moins performant sur des jeux de données très volumineux, pour de telles tailles il faut donc chercher d’autres solutions. De plus, la partie d’analyse prédictive de la solution n’est pas encore exhaustive en termes d’algorithmes de Machine Learning. La solution Spotfire Data Science de TIBCO (anciennement Alpine Data), similaire à Statistica dans son utilisation, est plus adaptée aux analyses prédictives et aux gros jeux de données.

En conclusion, les plateformes de Data Science sont un moyen pratique de créer et déployer des analyses de données sans avoir à tout développer avec Python ou sans passer par tout un ensemble d’outils spécialisés. Cela permet de réunir en un seul logiciel toutes les étapes d’une analyse. De plus, elles sont faciles d’utilisation et de compréhension, même pour des non-initiés à la Data Science, grâce à son système de workflows où tout le déroulement de l’analyse est visible sur un schéma unique.